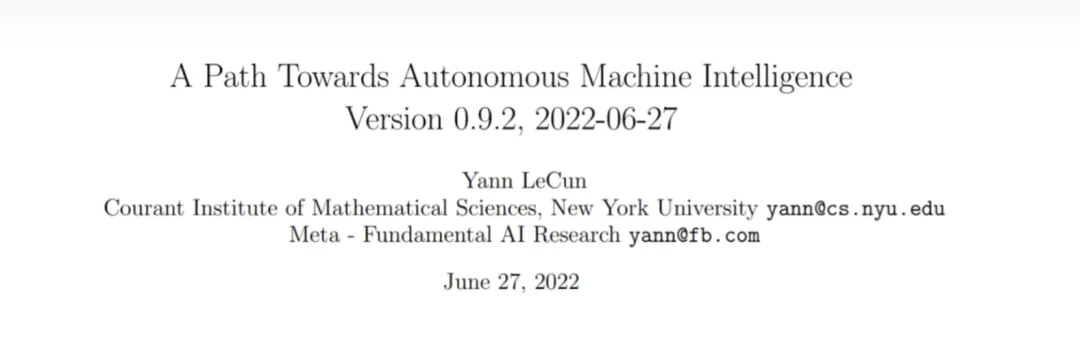

杨立昆2022年的一篇论文,提出了关于世界模型的论述。

杨立昆表示,如果向5个月大的婴儿展示将小汽车从平台上推下来,婴儿不会感到惊讶,但是10个月大的婴儿会非常惊讶。

·“如果向5个月大的婴儿展示将小汽车从平台上推下来,婴儿不会感到惊讶,但是10个月大的婴儿会非常惊讶,因为婴儿已经知道了物体应该在重力下下落。这些基本概念是通过观察世界和体验世界来习得的。研究者也应该用机器复制这种通过观察或体验世界来学习世界运作方式的能力。”

·“这就像你在1930年问航空工程师,你能把涡轮喷气发动机做得安全可靠吗?工程师会问,什么是涡轮喷气发动机?因为1930年还没发明出涡轮喷气发动机。”

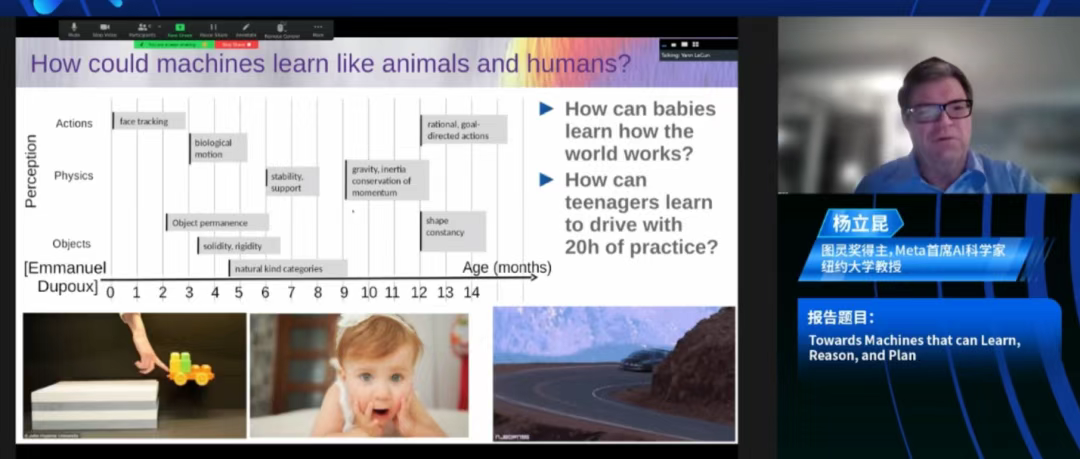

“本质上来说,人类和动物的能力和今天我们看到的AI的能力之间是有差距的。简单来说,机器学习和人类动物相比并不特别好。”6月9日,图灵奖得主、深度学习三巨头之一的杨立昆(Yann LeCun)在2023北京智源大会上表示。

在名为《走向能够学习、推理和规划的大模型》的线上演讲中,杨立昆讲述了他对大语言模型发展路线的系统思考。他认为,GPT这样的主流路线存在局限,想让AI获得如人一般对真实世界学习、应对和规划的能力,可以阅读他在一年前所发表的论文中提出的架构“自主智能(Autonomous Intelligence)”。

不看好自我监督学习

杨立昆表示,最近几年,科学家更多使用机器自我监督学习,但这些系统会犯愚蠢的错误,不会推理和规划,只是快速地反应。

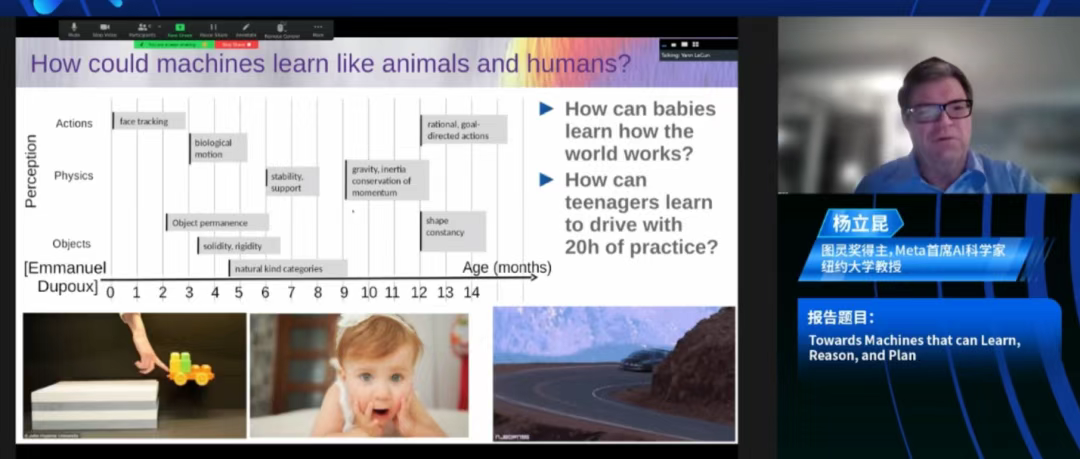

“那么,我们如何让机器像动物和人类一样理解世界的运作方式,并预测其行动的后果?”杨立昆问道。

在回答这个问题之前,首先要了解什么是自我监督学习。“自我监督学习捕捉输入中的依赖关系。在最常见的范例中,我们遮盖输入的一部分后将其反馈送到机器学习系统中,然后揭晓其余的输入——训练系统会捕捉看到的部分和尚未看到的部分之间的依赖关系。有时是通过预测缺失的部分来完成的,有时不完全预测。这种方法在自然语言处理的领域取得了惊人的成功。最近大模型的所有成功都是这个想法的一个版本。”他说。

“如果将这些模型训练在一万亿个Token或两万亿个Token的数据上,它们的性能是惊人的。但最终,它们会犯很愚蠢的错误。它们会犯事实错误、逻辑错误、不一致性,它们的推理能力有限,会产生有害内容。”杨立昆指出,“因为它们没有关于基础现实的知识,它们纯粹是在文本上进行训练的。这些系统在作为写作辅助工具、帮助程序员编写代码方面非常出色,但它们可能会产出虚构的故事或制造幻觉。”

AI面临的三个挑战

再来看看人类和动物。“我们看到婴儿在生命的前几个月内掌握了大量关于世界运作方式的基础概念:如物体永恒性、世界是三维的、有机和无机物体之间的区别、稳定性的概念、自然类别的学习以及重力等非常基本的概念。婴儿9个月大就能会这些。”杨立昆表示,如果向5个月大的婴儿展示将小汽车从平台上推下来,婴儿不会感到惊讶,但是10个月大的婴儿会非常惊讶,因为婴儿已经知道了物体应该在重力下下落。这些基本概念是通过观察世界和体验世界来习得的。研究者也应该用机器复制这种通过观察或体验世界来学习世界运作方式的能力。

杨立昆表示,如果向5个月大的婴儿展示将小汽车从平台上推下来,婴儿不会感到惊讶,但是10个月大的婴儿会非常惊讶。

如何做到这一点?杨立昆提出了未来几年AI面临的三个挑战。第一,学习世界的表征和预测模型;第二,学习推理。参考系统1和系统2的概念。系统1是与潜意识计算相对应的人类行为或行动,是无需思考即可完成的事情,系统2是有意识、有目的地运用全部思维力去完成的任务。目前,人工智能基本上只能实现系统1中的功能,而且并不完全;第三,如何通过将复杂任务分解成简单任务,以分层的方式运行来规划复杂的行动序列。

大约一年前,杨立昆发表了一篇论文。他说,那篇论文是关于他对未来10年人工智能研究走向的愿景。“在我提出的这个系统中,核心是世界模型(World Model)。世界模型可以为系统所用,它可以想象一个场景,基于这样的场景作为依据,预测行动的结果。因此,整个系统的目的是找出一系列根据其世界模型预测的行动,能够最小化一系列成本的行动序列。”

杨立昆2022年的一篇论文,提出了关于世界模型的论述。

AI与涡轮喷气发动机

在与清华大学教授、智源首席科学家朱军的对话环节中,杨立昆被问及对通用人工智能是否威胁人类的看法。据悉,他将参加一个辩论,与深度学习三巨头之一的约书亚·本吉奥(Yoshua Bengio)、未来生命研究所创始人迈克斯·泰格马克(Max Tegmark)和研究复杂系统的前沿科学家梅拉妮·米歇尔(Melanie Mitchell)探讨人工智能会不会成为人类生存的威胁。

“在这场辩论中,迈克斯·泰格马克和约书亚·本吉奥将站在“是”的一边,认为强大的AI系统可能对人类构成存在风险。而我和梅拉妮·米歇尔将站在“否”的一边。我们的论点不是说没有风险,而是这些风险虽然存在,但可以通过谨慎的工程设计轻易地加以减轻或抑制。”杨立昆说。

“今天问人们,我们是否能够确保超级智能系统对人类是安全的,这是无法回答的,因为我们还没有超级智能系统的完整设计。除非你有一个基本设计,否则你无法保证它安全。这就像你在1930年问航空工程师,你能把涡轮喷气发动机做得安全可靠吗?工程师会问,什么是涡轮喷气发动机?因为1930年还没发明出涡轮喷气发动机。”杨立昆打了这个比方,“所以,我们的处境有点相似。现在断言,我们不能确保这些系统安全有点为时过早,因为我们还没有发明出它们。”