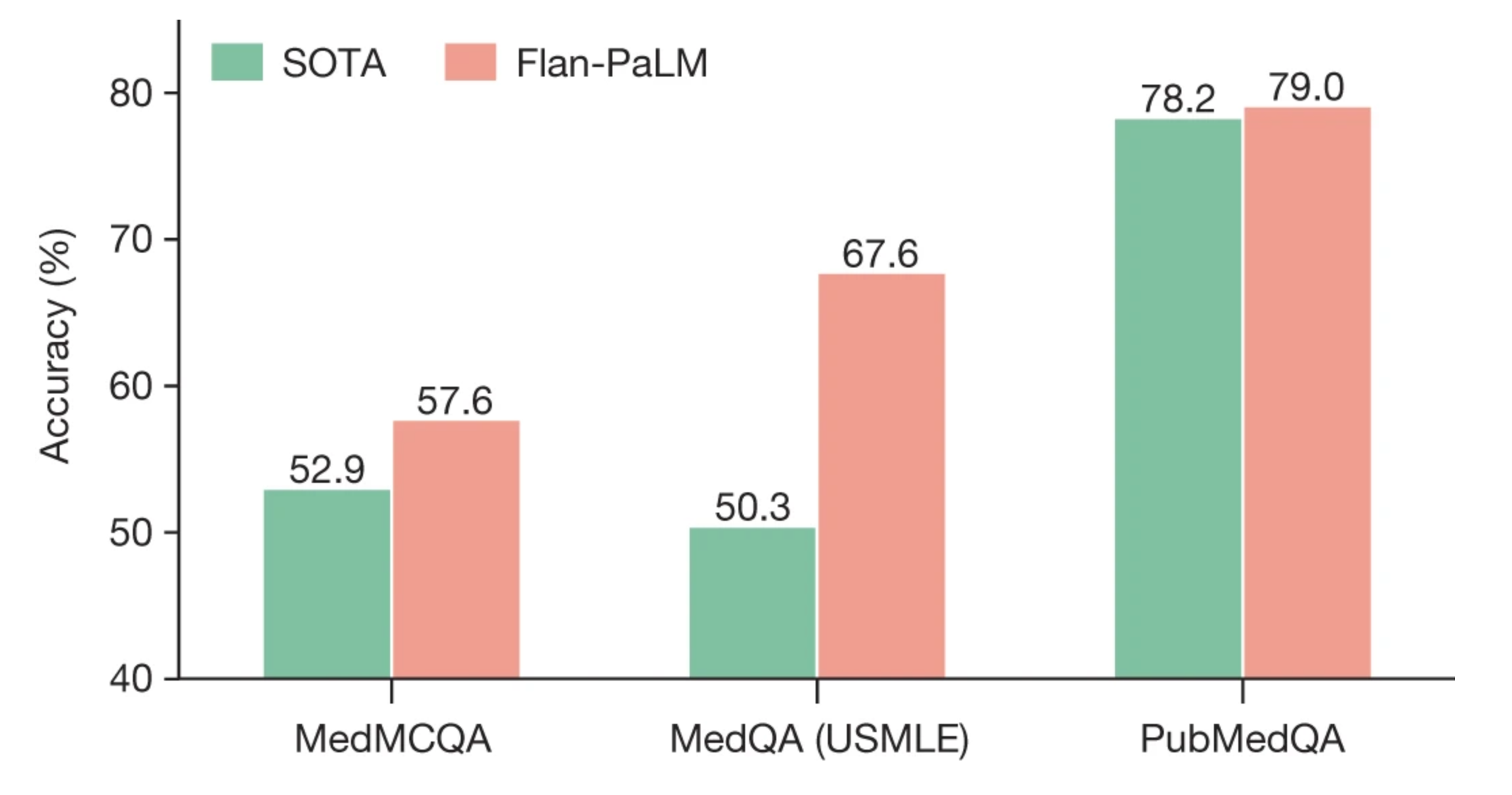

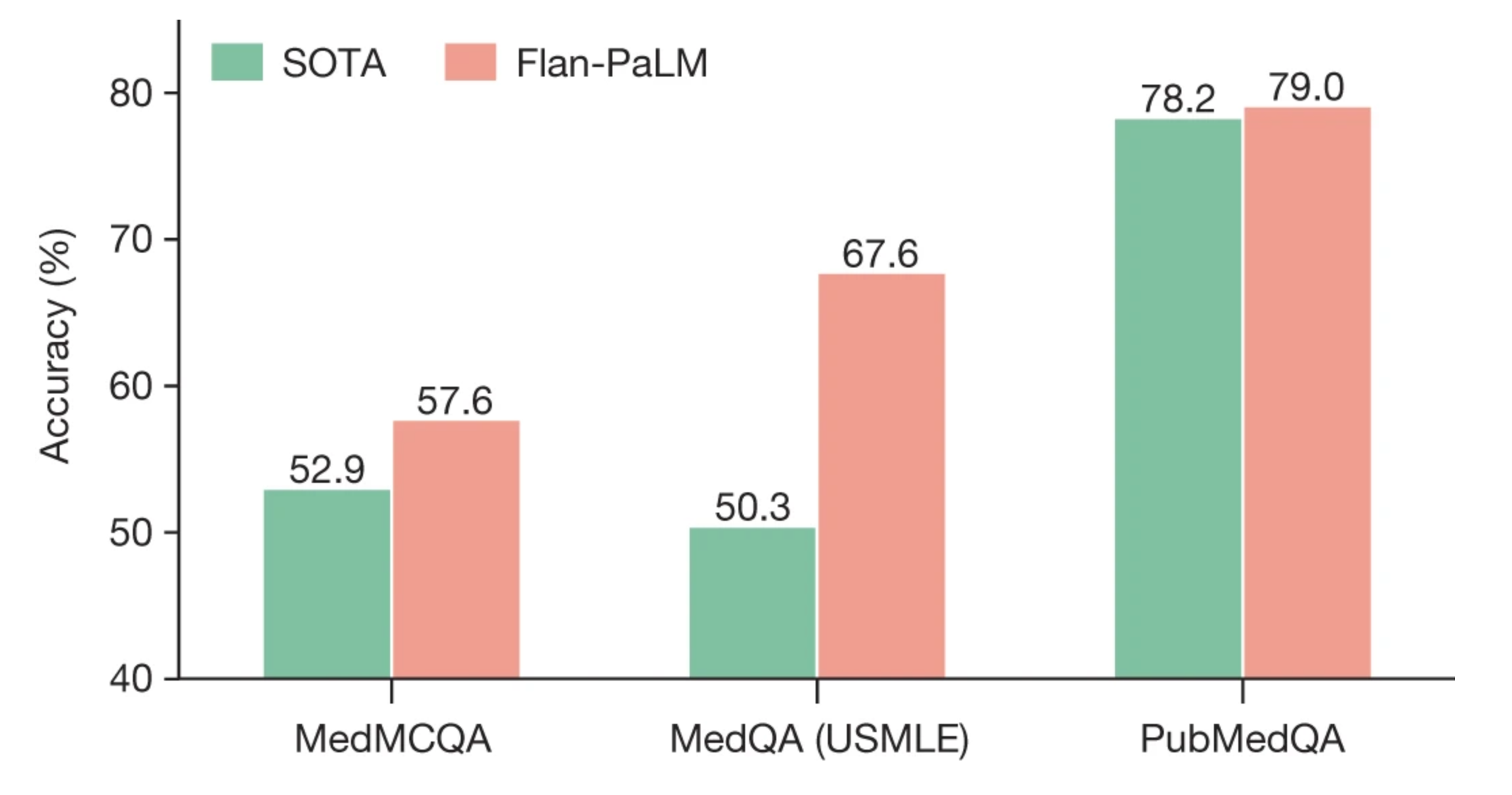

Flan-PaLM 540B模型在MedQA(4个选项)、MedMCQA和PubMedQA数据集上的性能超过了之前的一流水平(SOTA)。以前的一流水平来自Galactica20(MedMCQA)、PubMedGPT19(MedQA)和BioGPT21(PubMedQA)。每列上方显示的是准确率百分比。

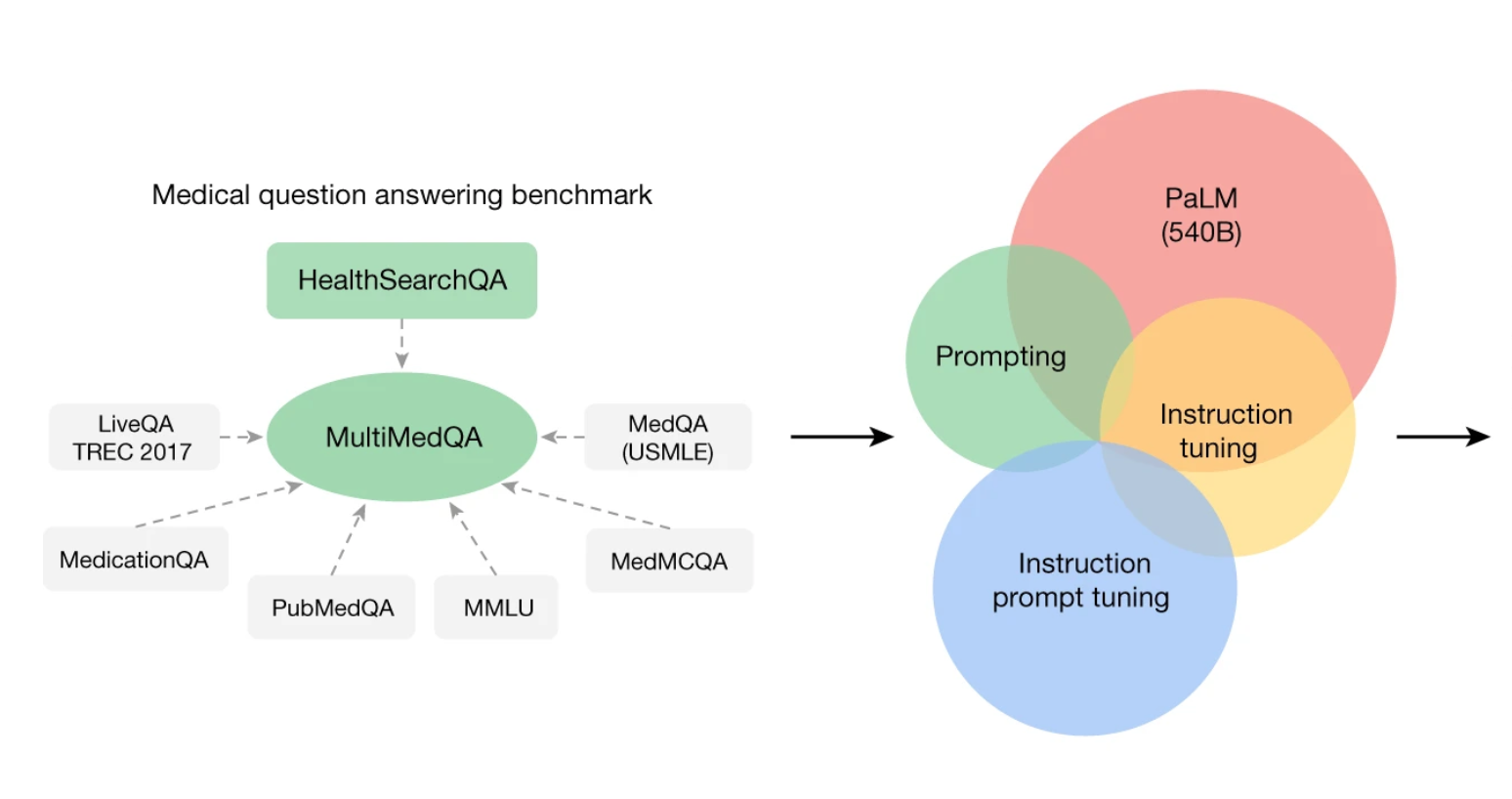

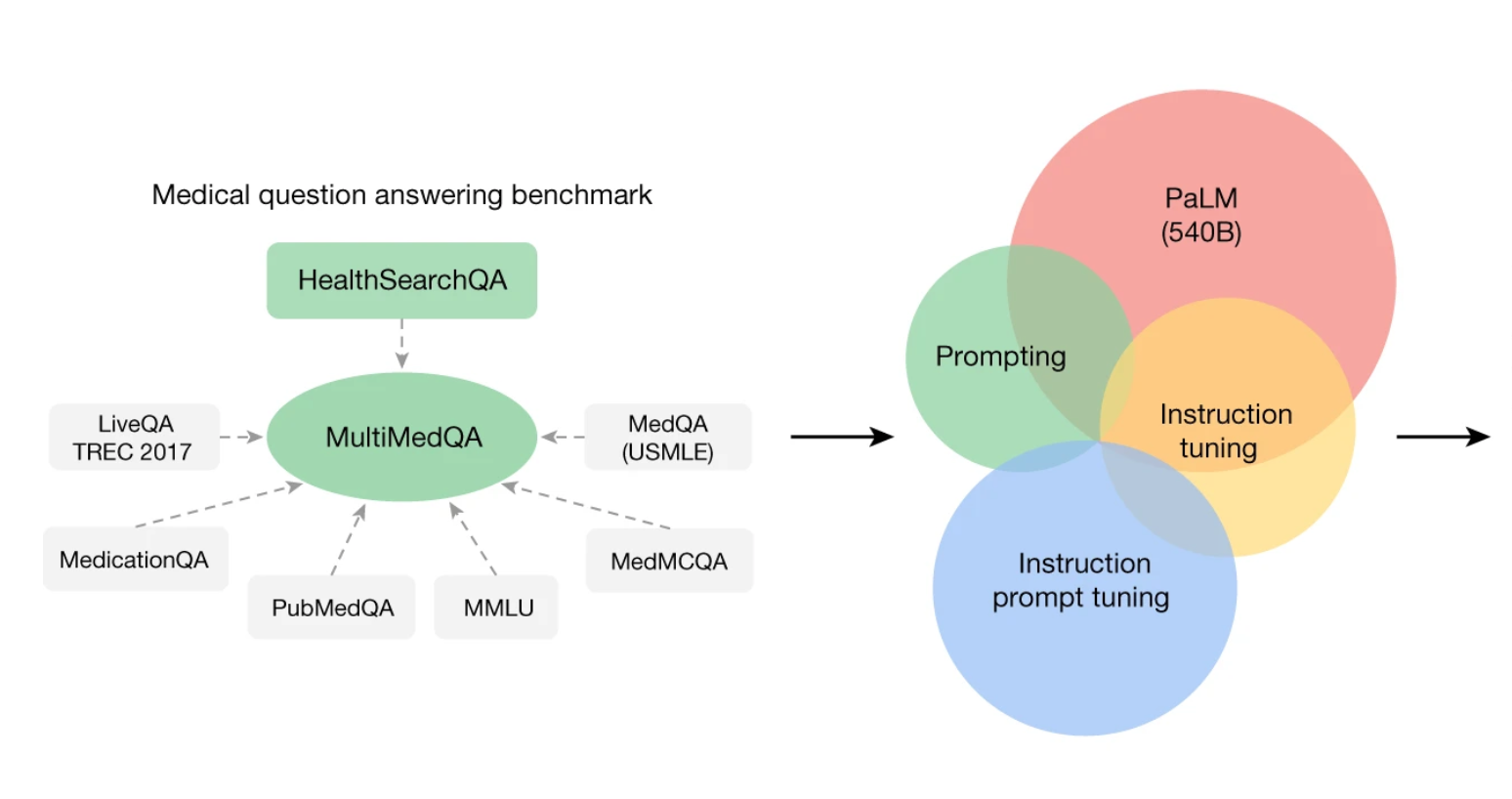

MultiMed QA结合了涵盖专业医学、研究和消费者查询的6个现有医学问答数据集,以及包含3173个在线搜索医学问题的新数据集HealthSearchQA,对PaLM进行了测试,并引入指令提示调整。

·研究人员提出一个评估基准来评测大语言模型在临床知识方面的表现,在引入指令提示调整后,由此产生的模型Med-PaLM表现令人鼓舞:92.6%的长篇答案符合科学共识,与临床医生生成的答案(92.9%)相当;5.9%的答案被评为可能导致有害结果,与临床医生生成的答案(5.7%)的结果相似。

·“但是房间里有一头大象,这就是‘医学问题’和实际行医之间的区别。行医并不只是回答医学问题,如果纯粹是回答医学问题,我们就不需要教学医院,医生也不需要在学术课程之后接受多年的培训。”

大语言模型已展现出令人印象深刻的功能,但临床应用的门槛仍然很高。人们敢相信AI医生吗?如何评估AI问诊有效性?在回答这些问题之前,医学界急需一个评测标准来鉴定。

当地时间7月12日,Google和DeepMind的科研人员在《自然》杂志上发表一项研究,提出了MultiMed QA评估基准,用于评测大语言模型在临床知识方面的表现。结果研究人员发现,大语言模型构建的AI医生在很多方面与人类医生相当。

谷歌的研究人员表示,这项技术不会威胁到全科医生的工作,但未来可能可以用于医疗求助热线。

“医学是一项人性化的事业,语言为临床医生、研究人员和患者之间的关键互动提供了可能。然而,当今用于医学和医疗保健应用的人工智能(AI)模型在很大程度上未能充分利用语言。”论文写道,“这些模型虽然有用,但主要是单任务系统(例如用于分类、回归或分割),缺乏表达性和交互能力。因此,当今模型的功能与现实临床工作流程中的预期之间存在不一致。”

MultiMed QA结合了涵盖专业医学、研究和消费者查询的6个现有医学问答数据集,以及包含3173个在线搜索医学问题的新数据集HealthSearchQA。研究者为模型的回答提出了一个人类评估框架,包括事实性、理解性、推理、可能的伤害和偏见几个指标。

MultiMed QA结合了涵盖专业医学、研究和消费者查询的6个现有医学问答数据集,以及包含3173个在线搜索医学问题的新数据集HealthSearchQA,对PaLM进行了测试,并引入指令提示调整。

然后,研究人员对大语言模型PaLM以及其变体Flan-PaLM进行了测试。通过结合提示策略,Flan-PaLM在每个MultiMedQA多项选择数据集上都取得了较高的准确度,包括在MedQA(美国医疗执照考试类型问题)上准确率达67.6%,比之前最先进的大语言模型还要高17%。

尽管Flan-PaLM在多项选择题上表现强劲,但其对消费者医疗问题的回答却暴露出关键差距。为了解决这个问题,研究人员引入了指令提示调整,可以使用一些示例将大预言模型与新领域对齐。由此产生的模型Med-PaLM表现令人鼓舞。例如,临床医生小组认为,Flan-PaLM只有61.9%的长篇答案符合科学共识,而Med-PaLM答案的这一比例为92.6%,与临床医生生成的答案(92.9%)相当。同样,Flan-PaLM 29.7%的答案被评为可能导致有害结果,而Med-PaLM的这一比例为5.9%,这与临床医生生成的答案(5.7%)的结果相似。

Flan-PaLM 540B模型在MedQA(4个选项)、MedMCQA和PubMedQA数据集上的性能超过了之前的一流水平(SOTA)。以前的一流水平来自Galactica20(MedMCQA)、PubMedGPT19(MedQA)和BioGPT21(PubMedQA)。每列上方显示的是准确率百分比。

研究者提出,随着模型规模和指令提示的调整,理解力、知识回忆和推理能力得到提高,这表明大语言模型在医学领域具有潜在用处。不过,“尽管这些结果很有希望,但医学领域很复杂。进一步的评估是必要的,特别是在安全性、公平性和偏见方面。”

论文作者维韦克·纳塔拉扬(Vivek Natarajan)博士表示:“我们希望医生能够信任这个项目。当人们转向互联网获取医疗信息时,他们会遇到信息超载,因此他们可以从10种可能的诊断中选择最坏的情况,并承受很多不必要的压力。这种语言模型将提供简短的专家意见,不带偏见,引用其来源并表达任何不确定性。”

此外,这个项目可以用于分诊,了解人们的病情有多紧急,再让他们排队接受治疗。“当我们缺乏专业医生时,我们需要这个来提供帮助,这将使他们能够腾出时间来完成自己的工作。这确实令人兴奋,医生们不必担心人工智能会抢走他们的饭碗,因为这只会让他们有更多的时间与病人相处。”

然而,巴斯大学教授詹姆斯·达文波特(James Davenport)告诉《每日邮报》:“新闻稿描述了这篇论文如何推进我们使用大型语言模型回答医学问题的知识,就其本身而言是准确的。但是房间里有一头大象,这就是‘医学问题’和实际行医之间的区别。行医并不只是回答医学问题,如果纯粹是回答医学问题,我们就不需要教学医院,医生也不需要在学术课程之后接受多年的培训。”