“特朗普被逮捕了!!!”

“消息”首先在 Twitter 傳開,熱度蹭蹭地竄升。“始作俑者” Eliot Higgins 馬上出來澄清:“别誤會了,照片是我用 Midjourney 生成的,爲此還花錢買了 V5 版本。”

特朗普被捕了丨來自 Twitter @Eliot Higgins

但來不及了,這一系列照片(因爲Higgins還連載了“入獄”後續)在 Instagram、TikTok 上“瘋傳”,全民狂歡的勁頭就像一起經曆真實的政治事件——川普“入獄”、“越獄”、“出獄”、“再就業”等等層出不窮。

特朗普的獄中生活丨來自 Twitter@Eliot Higgins

由 AI 生成的内容“謊騙”過人眼,起初人們還挺興奮,但問題是,這種興奮在最近發生得過于頻繁,它開始轉變爲一種惶恐。

圖像之外,還有文字——包括 Science、Nature 等在内的學術期刊對于 ChatGPT 的使用明令限制,不許将其列爲論文合著者;一些高校甚至中學老師開始頻繁抱怨,學生用 AI 生成的作業越來越多,也越來越難以甄别。

那麽,在目前這個階段,我們還剩下哪些辦法能識别出“AI 出品”呢?

讓 AI 指認 AI:26%,我說的是準确率

如果你也一瞬間将“川普入獄圖”信以爲真,或根本讀不出一篇中規中矩的新聞稿究竟是否出自人類之手,别懊惱!這确實不太容易。

幾年前 Deepfake 換臉圖片中,還常會因爲臉部圖像疊加不好,出現“雙下巴”等醒目的錯亂。然而今天 Midjourney 連結構最難把握的手都能畫好了。

Deepfake 臉部重合問題丨源自 Medium 作者 Jonathan Hui

就連 AI 自己,對于什麽内容是自己生成的,也不太确信。OpenAI 做了一個分類模型(ai text classifier)檢測器(detector)(https://platform.openai.com/ai-text-classifier),在英文文本的評估中,正确識别了 26% 的 AI 生成文本,錯誤地将 9% 的人類文本标記爲 AI 文本。

起初我對此結果存疑。直到我讓 Bing 以“春”、“夏”、”秋”、“冬”爲話題分别寫四首詩,并交給 OpenAI 的檢測器來判斷。不幸的是,它給出的結果,分别是“文本非常不可能是 AI 寫的”,“不可能是 AI 寫的”,“不可能是 AI 寫的”,“不可能是 AI 寫的”——正确率爲零。

OpenAI自己的 AI 識别工具,以及市面上另一家 originality.ai 做的檢測器本質上都是“語言模型”——就跟 ChatGPT 一樣。

OpenAI 識别局限丨源自 OpenAI

Originality.ai (基于 Transformer )搭建了全新架構,在此之上訓練一個預訓練語言模型。然後用建立在數百萬個樣本上的訓練集對模型進行微調。輸入一旦超過模型既定的阈值,就界定該内容是被 AI 生成的。

爲了提升準确性,這類工具在生成訓練數據中,要盡可能生成多樣化的數據(用不同生成方式,和用多個生成模型),以便模型更好地知道 AI 生成的文本類型。

利用現有的人類創作的文本數據對模型進行微調,使 AI 生成的文本更加自然(也就是更像“人話”),以便模型能學到,即便 AI 生成的文本越來越有“迷惑性”,但跟人類之間那個微妙的邊界仍然存在——這聽起來更像 AI 假“識别”之名行模仿之事。

但至少目前,跨沒跨過那個“邊界”總有一些标準。GPTZero (也是一款 AI “殺手”,https://gptzero.me/)在辨别一段輸入是不是由 AI 生成的,它借助兩個文本屬性,困惑性(perplexity)、突發性(burstiness)。

“困惑性”是指一段文本的複雜性和随機性。模型接受生成的文本數據集訓練,所以機器下一個詞接什麽,下一句話說什麽,可預測性更高。然而人類遣詞造句的随機性就高了,說出的話更加讓機器意想不到。

“突發性”則指句子之間的變化程度。人類寫作,有更多的句子結構變化,長、短句,複雜、簡潔句交替使用。機器生成的句子往往更加統一。

但模型的漏洞很容易鑽。AI 生成的内容與日俱增,對一份全然不同于,且從未在訓練集中出現的内容,AI 極有可能預測錯誤;短文本對于模型來說簡直是災難,因爲文本越短,呈現的變化可能性越少,OpenAI 要求輸入的文本至少有 1000 個字符。

那麽 AI “鑒”畫的成績有好點嗎?

很遺憾,也沒有。

一位開發者 Matthew Maybe 在開發者社區上傳了自己的 image detector。(https://huggingface.co/spaces/umm-maybe/AI-image-detector)

實際上,他就是訓練了一個圖片二分類模型。訓練數據全部來自 Reddit,真實圖片來自 r/art 等版塊,AI 圖片來自 r/midjourney 等版塊,并“手動”爲這些圖片打了标簽。

後來經朋友提醒,還将真實圖片上傳日期限制在 2019 年之前,避免有 AI 生成圖片的混入。

使用評價褒貶不一,Reddit 用戶說,說不好是不是靠猜的。因爲他用戶訓練的數據樣本太少,隻有幾千個。另外他“故意”不去解決,由計算機處理過(可能指 PS 等軟件),而非 AI 生圖所造成的判斷結果“假陽性”問題。

“與其做一個完美模型,我更想對藝術家負責。”以至于,模型在判斷是不是“真”圖上,給出結果也有保守“傾向”。

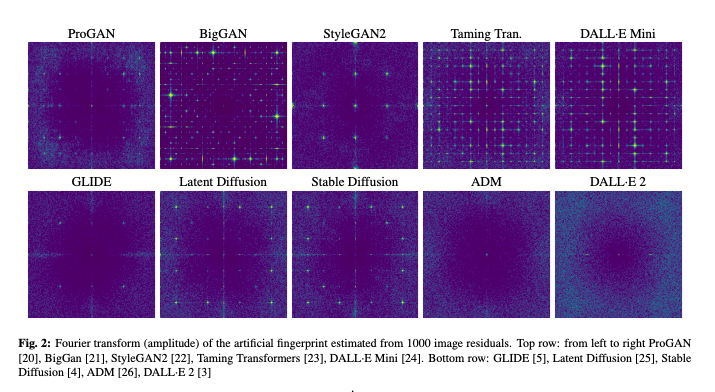

研究者們認爲,即便一張圖片肉眼看起來“完美”,由于生成過程會留下痕迹,讓它仍能被識别出來是AI畫的。這些生成痕迹,與攝像頭拍攝留下的“标識”不同。而且每個生成算法留下各自獨特痕迹,以便溯源。

過往在基于 GANs(生成式對抗網絡)的 deepfakes “換臉術”中,通過找生成痕迹的檢測方法被證明是有效的。

于是上述研究者們想,類似方法能否用于這段時間發展起來的 AI 生圖所基于的擴散模型上。他們發現,擴散模型留下的痕迹,普遍不如 GANs 明顯。例如 Stable Diffusion 的痕迹雖弱,但尚可用來檢測,DALL-E 2 幾乎不可見。

生成痕迹在 DALL-E2 中幾乎不可見丨源自參考文獻[7]

基于模型之間的差距,以及對現有 detectors 做了效果評估之後,他們得出結論,現有 detectors 最大問題是“通用性”。

引入一個擴散模型生成的圖片用以訓練,可以幫助檢測出類似模型生成的圖片,但對其他的檢測效果就不好。一個模型是爲 GANs 訓練的,它很難檢測出基于擴散模型的生成圖片。

以及當圖片因爲在社交媒體上經常被壓縮、裁剪,從而質量有所下降,detectors 識别起來就有困難。

先是信不過AI,然後就是人類的相互猜忌

但今天的 AI 畫圖,不見得找不出一點錯。有的時候畫面缺少 3D 建模;在陰影和反射畫面中不對稱。肉眼挑錯的方法雖不是長久之計,但至少是目前最可行的辦法。

比如在特朗普被捕的這些照片中。打眼一看畫面主體好像沒問題,但仔細一看,畫面人物越多,“詭異”的事情越多。

比如“多腿”特朗普;

圖片來源 Twitter @Eliot Higgins

特朗普膚色不自然,面部呈現一種“蠟質”的不真實;以及找不到主人的手;

圖片來源 Twitter @Eliot Higgins

警察的帽子和徽章都模糊處理,細看甚至不盡相同;

圖片來源 Twitter @Eliot Higgins

當 AI 表現人物表情,往往以一種比較誇張的方式呈現。(有的時候就連微笑所帶來的皮膚褶皺都畫得非常明顯);

圖片來源 Twitter @Eliot Higgins

以及 AI 似乎還沒學會“眼神追蹤”,一群追趕特朗普的人,他們看向的方向都不相同。

圖片來源 Twitter @Eliot Higgins

而在普通人眼中認爲完美的 AI 藝術,也在經驗老道的藝術家那裏形成了一套“經驗主義”。

一名 3D 角色藝術家(Dan Eder)說,“如果想試圖辨認一張 AI 生成圖像,應該考慮作品的整體設計。假設 AI 畫了一張“幻想戰士盔甲”,乍一看,很漂亮,細節也很豐富,但很多時候這背後沒有“邏輯”。邏輯是指,當一位人類藝術家爲角色創作盔甲,他得考慮到,這件盔甲的功能性,肢體位置,要能展開多少。”

另一位藝術家則說,AI 生成的圖像缺乏“意向性”(指人類的每一個覺知都是指向外部事物),AI 沒什麽經驗基礎,能理解人、樹、手……是什麽。“所有這些都是剛被扔進畫面裏的,爲了讓你的提示詞和數據點對應起來。這是它能呈現的最接近的東西,但不知道爲什麽。”

即便藝術家們聲稱:AI 做圖缺少一種清晰的視覺叙事。但這種說法也被認爲是一種“事後諸葛亮”。

去年年底,一位數字藝術家 Ben Moran 發推,抱怨自己的作品被 r/Art 版塊審核員“禁了”,原因是違法了“no AI art”規則。這幅“戰區缪斯”(a muse in warzone)風格的确類似很多 AI 生成藝術(在當時)——文藝複興繪畫風格,穿着戰士服的女性。

Moran 自證丨圖片來源 Ben Moran

Moran 說,“不信,我交出 PSD 文件。”審核員卻說,“不必!如果你是一個‘正經兒’藝術家,你得畫些其他風格。口說無憑,因爲不會有人再相信,AI 沒‘替’你畫畫。”

AI 學習網絡上大量畫作,從而形成自己“傾向性”的風格,這本不是人類的錯。AI 生成内容逼近肉眼可辨的真實,連内容創作“金字塔”尖的藝術家們也需要自證。諷刺的是像上述例子,爲了自證,人類需要主動“避開” AI 所“擅長”的東西了。

參考文獻

作者:沈知涵

編輯:卧蟲

一個AI

AI:這把我不行了,你行你上吧!

本文來自果殼,未經授權不得轉載.

如有需要請聯系sns@guokr.com